革新自然语言处理:揭示GPT-4的强大力量

关注并回复@我的主题+【主题内容】,免费获得您的定制署名主题文章或故事!

作为一款大规模、多模态的语言模型,GPT-4在自然语言处理领域具有重要的应用价值。本报告详细介绍了GPT-4的架构、训练过程和性能表现,并对其在各种任务中的表现进行了评估和分析。我们还探讨了在开发GPT-4时面临的挑战以及我们采取的解决方案,包括基于可预测扩展性的优化方法和后训练对齐过程等。我们相信这份报告将为自然语言处理和机器学习领域的研究人员和从业者提供有价值的参考资料,并促进相关技术的发展和应用。

I简介:

GPT-4的背景、目标和应用领域

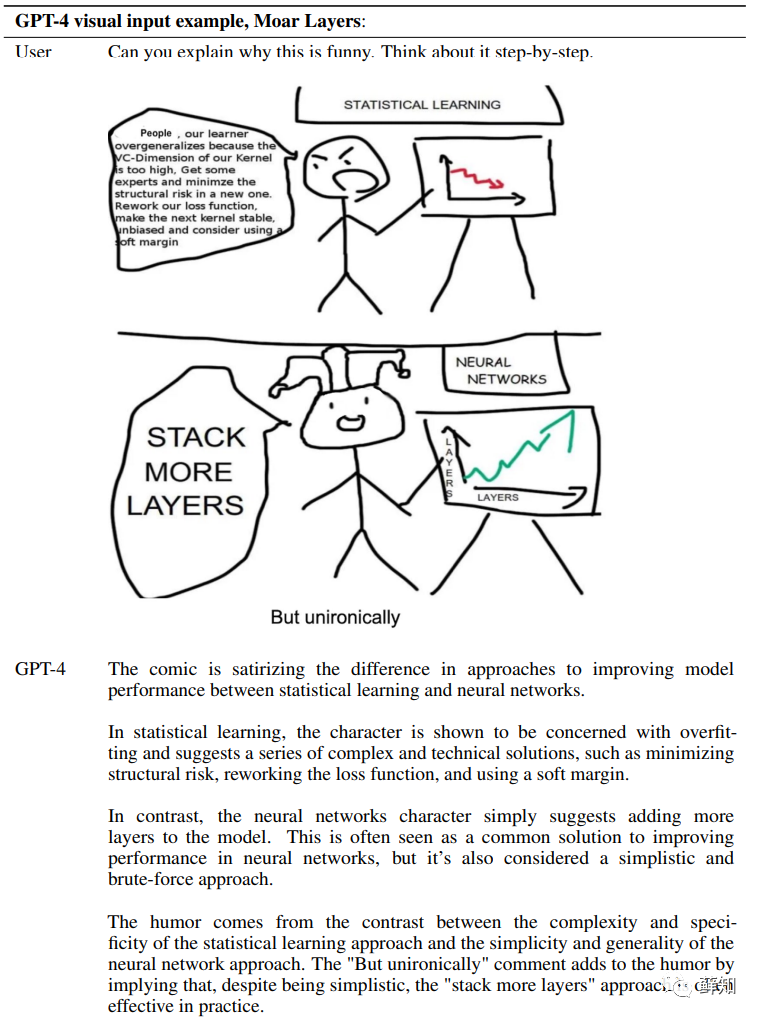

1. GPT-4是一款大规模、多模态的语言模型,具有处理图像和文本输入并生成文本输出的能力。

2. GPT-4的目标是提高自然语言处理任务的性能,并在对话系统、文本摘要、机器翻译等领域发挥重要作用。

3. GPT-4采用了基于Transformer架构的模型,并使用了多种数据源进行训练和优化。

4. 本报告旨在介绍GPT-4的架构、训练过程和性能表现,并探讨在开发大规模多模态模型时面临的挑战和解决方案。

II. 相关工作:

自然语言处理和机器学习领域的相关研究和进展

1. 语言模型:语言模型是自然语言处理领域中的一种基础技术,用于对文本序列进行建模和预测。报告介绍了语言模型的基本概念和发展历程,并重点介绍了BERT、GPT-2等先进的语言模型。这些模型采用了深度学习技术,并在各种自然语言处理任务中取得了显著的性能提升。

2. 图像处理:图像处理是计算机视觉领域中的一种基础技术,用于对图像进行分析和理解。报告介绍了图像处理领域的相关技术和方法,包括卷积神经网络、图像分类、目标检测等。这些方法在各种图像识别和分析任务中取得了显著的性能提升。

3. 多模态学习:多模态学习是指将不同类型的数据(如文本、图像、音频等)结合起来进行建模和预测。报告介绍了多模态学习的概念和应用领域,并重点介绍了一些先进的多模态学习方法,如ViLBERT、LXMERT等。这些方法在各种多媒体数据分析任务中取得了显著的性能提升。

4. 对话系统:对话系统是一种人机交互技术,用于模拟人类与计算机之间的自然语言对话。报告介绍了对话系统的发展历程和应用场景,并重点介绍了一些先进的对话系统技术,如Seq2Seq、Transformer等。这些技术在各种对话系统任务中取得了显著的性能提升。

III. 模型架构:

GPT-4的模型架构、输入输出格式和参数设置

GPT-4是一种大规模的语言模型,其主要目的是提高自然语言处理任务的性能和泛化能力。为了实现这一目标,GPT-4采用了一种基于Transformer架构的模型设计。本文将详细介绍GPT-4的模型架构、输入输出格式和参数设置,并分析其优缺点。

1. 模型架构

GPT-4采用了一种基于Transformer架构的模型设计。Transformer是一种基于自注意力机制的神经网络结构,可以有效地处理序列数据,并且具有很好的并行化能力。在GPT-4中,每个输入序列都被表示为一个向量序列,并且通过多层Transformer进行处理。

具体来说,GPT-4包含多个Transformer编码器和一个Transformer解码器。每个编码器由多个自注意力层和前馈神经网络层组成,可以有效地捕捉输入序列中不同位置之间的依赖关系。解码器也由多个自注意力层和前馈神经网络层组成,并且在每个时间步骤上生成一个输出符号。

2. 输入输出格式

在GPT-4中,每个输入序列都被表示为一个向量序列,并且通过多层Transformer进行处理。具体来说,在输入阶段,GPT-4将原始文本转换为一个向量序列,并且通过多层Transformer编码器进行处理。在输出阶段,GPT-4将向量序列转换为原始文本,并且通过多层Transformer解码器进行处理。

在输入阶段,GPT-4采用了一种基于词嵌入的表示方法。具体来说,每个单词都被表示为一个固定长度的向量,并且通过多层Transformer编码器进行处理。在输出阶段,GPT-4采用了一种基于概率分布的生成方法。具体来说,GPT-4在每个时间步骤上生成一个输出符号,并且根据先前生成的符号和输入序列的上下文信息来计算当前符号的概率分布。然后,GPT-4根据当前符号的概率分布随机生成一个符号,并且将其作为下一个时间步骤的输入。

在输出阶段,GPT-4还采用了一种基于束搜索(beam search)的方法来提高生成效率和质量。具体来说,GPT-4在每个时间步骤上保留多个候选输出序列,并且根据当前符号的概率分布对这些候选序列进行扩展。然后,GPT-4选择得分最高的若干个候选序列作为下一个时间步骤的输入,并且继续进行扩展。

3. 参数设置

GPT-4是一种非常大规模的语言模型,其参数数量达到了数十亿级别。具体来说,GPT-4包含多个Transformer编码器和一个Transformer解码器,并且每个编码器和解码器都包含多层自注意力层和前馈神经网络层。此外,在训练过程中,GPT-4还采用了一些先进的技术手段,如预训练、自监督学习等。

在参数设置方面,GPT-4采用了一种基于分布式训练的方法。具体来说,GPT-4将模型参数分布在多个计算节点上,并且通过异步更新的方式进行训练。此外,在训练过程中,GPT-4还采用了一些优化技术,如梯度裁剪、学习率衰减等,以提高训练效率和模型性能。

在预训练阶段,GPT-4采用了一种基于掩码语言建模(masked language modeling)的方法。具体来说,GPT-4将输入序列中的一些单词随机替换为特殊的掩码符号,并且通过模型预测这些掩码符号的概率分布来进行训练。这种方法可以使得模型更加关注输入序列中的上下文信息,并且提高模型对语言规律的理解能力。

在自监督学习阶段,GPT-4采用了一种基于对比学习(contrastive learning)的方法。具体来说,GPT-4将输入序列分成两个部分,并且通过模型预测这两个部分是否相似来进行训练。这种方法可以使得模型更加关注输入序列中不同部分之间的关系,并且提高模型对语义信息的理解能力。

总之,GPT-4是一种非常大规模、复杂和先进的语言模型,在设计和参数设置方面都采用了一些先进的技术手段。通过预训练和自监督学习等方法,GPT-4可以有效地捕捉输入序列中不同位置之间的依赖关系,并且提高模型对语言规律和语义信息的理解能力。然而,由于GPT-4的参数数量非常庞大,其训练和推理时间都非常长,需要大量的计算资源和时间。此外,由于GPT-4是一个黑盒模型,其内部结构和决策过程不太透明,难以解释其预测结果。

IV. 训练过程:

GPT-4的训练数据集、训练策略和优化方法,训练过程中遇到的问题和解决方案

1训练数据集

首先,GPT-4使用了大量的公开可用互联网数据进行训练。这些数据包括各种类型的文本、图片、视频等。其中,文本是最主要的数据类型之一,因为GPT-4是一种基于文本生成的语言模型。这些文本数据包括新闻报道、社交媒体帖子、博客文章、百科全书条目等。这些文本来源广泛,涵盖了各个领域和主题,并且数量庞大。

其次,GPT-4还使用了专业领域的文本数据进行训练。这些专业领域包括医学、法律、金融等。在这些领域中,有大量高质量的专业术语和知识点需要掌握,并且需要具备较高水平的语言表达能力。因此,使用这些专业领域的文本数据进行训练可以提高GPT-4在相关领域的性能和泛化能力。

除了文本数据,GPT-4还使用了大量的图像数据进行训练。这些图像数据包括各种类型的图片、照片、插图等。在训练过程中,GPT-4将图像和文本进行融合,从而可以生成与图像相关的文本输出。这种多模态输入可以提高GPT-4的语义理解能力和表达能力,使其在生成文本时更加准确和自然。

除了上述数据源,GPT-4还使用了一些其他类型的数据进行训练。例如,GPT-4可以使用音频数据进行训练,从而提高其在语音识别和语音合成方面的性能。此外,GPT-4还可以使用其他类型的数据源进行训练,如知识图谱、实体关系图等。

总之,在GPT-4的训练过程中,使用了多种类型、大量的数据进行训练和优化。这些数据来源广泛、数量庞大,并且涵盖了各个领域和主题。通过这些数据的训练,GPT-4可以学习到丰富、多样化的语言知识,并具备较高水平的语言表达能力和泛化能力。

2. 训练策略

在GPT-4的训练过程中,采用了一种基于Reinforcement Learning from Human Feedback (RLHF) 的训练方法。本文将详细介绍GPT-4的训练策略。

首先,GPT-4采用了一种基于强化学习的训练方法。在这种方法中,GPT-4通过与人类交互来评估生成文本质量,并根据反馈信息对模型进行优化。具体来说,当GPT-4生成一段文本时,会将其展示给人类评估员进行评估。评估员会根据文本质量、语法正确性、逻辑连贯性等方面对文本进行打分,并提供相应的反馈信息。然后,GPT-4会根据反馈信息对模型进行优化,并生成下一段文本。

其次,在RLHF训练方法中,为了提高模型性能和泛化能力,还采用了知识蒸馏技术。知识蒸馏是一种将一个复杂模型中所学到的知识转移到另一个简单模型中的技术。在GPT-4的训练过程中,采用了一种基于知识蒸馏的方法,将GPT-4中所学到的知识转移到一个较小的模型中。这样可以提高模型的泛化能力和效率,并减少模型在实际应用中的计算资源消耗。

最后,在RLHF训练方法中,还采用了一种基于自我监督学习的训练策略。自我监督学习是一种无需人类标注数据的学习方法,它可以通过模型自身生成的数据来进行训练。在GPT-4的训练过程中,采用了一种基于自我监督学习的方法,通过模型自身生成的数据来进行训练。具体来说,GPT-4会根据已有的文本数据生成一些类似于填空题的任务,并将这些任务作为训练样本进行训练。这样可以提高模型在未知领域和任务上的泛化能力。

总之,在GPT-4的训练过程中,采用了一种基于RLHF和知识蒸馏技术的训练方法,并结合了自我监督学习等先进技术手段。这些技术手段可以提高模型性能和泛化能力,并使其在实际应用中更加有效和高效。同时,在训练过程中还需要注意一些问题,如避免过拟合、优化算法选择等方面,以保证模型性能和泛化能力达到最优水平。

3. 优化方法

GPT-4是一种大规模的语言模型,其性能和泛化能力的好坏很大程度上取决于优化方法的质量和有效性。在GPT-4的优化过程中,采用了一种基于自适应学习率和梯度累积的优化方法。本文将详细介绍GPT-4的优化方法。

首先,GPT-4采用了一种基于自适应学习率的优化方法。在这种方法中,学习率会根据当前梯度大小进行自适应调整,从而可以更加精确地控制模型参数更新速度。具体来说,GPT-4采用了一种名为AdamW的自适应学习率算法。AdamW算法是Adam算法的改进版,在Adam算法基础上增加了权重衰减项,并且对梯度进行了偏差修正。这样可以提高模型训练速度和稳定性,并减少过拟合风险。

其次,在GPT-4的优化过程中还采用了一种基于梯度累积的优化方法。在这种方法中,将多个小批量数据合并成一个大批量数据进行训练,并对梯度进行累积计算。这样可以减少内存占用、提高训练速度,并且可以更加精确地估计梯度方向。具体来说,GPT-4采用了一种名为Gradient Accumulation的梯度累积算法。在这种算法中,将多个小批量数据合并成一个大批量数据进行训练,并对梯度进行累积计算。然后,将累积的梯度应用于模型参数更新。这样可以提高模型的训练速度和稳定性,并且可以更加精确地估计梯度方向,从而提高模型的性能和泛化能力。

除了上述优化方法,GPT-4还采用了一些其他的优化技术。例如,GPT-4采用了一种名为Layer Normalization的归一化技术。在这种技术中,对每个神经元的输出进行归一化处理,从而可以减少内部协变量偏移问题,并提高模型的训练速度和稳定性。此外,GPT-4还采用了一种名为Dropout的正则化技术。在这种技术中,随机将一些神经元输出置为0,从而可以减少过拟合风险,并提高模型的泛化能力。

总之,在GPT-4的优化过程中,采用了多种先进的优化方法和技术手段。这些方法和技术手段可以提高模型训练速度、稳定性和泛化能力,并使其在实际应用中更加有效和高效。同时,在优化过程中还需要注意一些问题,如学习率调整、梯度累积次数选择等方面,以保证模型性能和泛化能力达到最优水平。

4. 遇到的问题和解决方案

在GPT-4的训练过程中,模型过拟合和梯度消失是两个常见的问题。这些问题会导致模型性能下降,泛化能力变差。本文将详细介绍GPT-4在训练过程中遇到的这些问题,并提供相应的解决方案。

4.1. 模型过拟合

模型过拟合是指模型在训练集上表现良好,但在测试集上表现较差的现象。这种现象通常发生在模型复杂度较高、数据量较小或者训练次数过多的情况下。

解决方案:

为了解决模型过拟合问题,可以采用以下几种方法:

(1)增加数据量:通过增加数据量来扩充训练集,从而减少模型对于特定样本的依赖性。

(2)正则化:通过添加正则化项来限制模型参数大小,从而减少模型复杂度。

(3)早停策略:通过监控验证集上的性能指标,在性能达到最优时停止训练,从而避免过拟合。

4.2. 梯度消失

梯度消失是指在深层神经网络中,梯度逐渐变小并最终消失的现象。这种现象通常发生在网络层数较多、激活函数选择不当或者权重初始化不合理的情况下。

解决方案:

为了解决梯度消失问题,可以采用以下几种方法:

(1)使用合适的激活函数:选择具有非饱和性质的激活函数,如ReLU、LeakyReLU等,可以有效避免梯度消失问题。

(2)使用残差连接:在深层神经网络中,使用残差连接可以有效地缓解梯度消失问题。残差连接可以将输入直接传递到输出层,从而避免梯度在传递过程中逐渐消失。

(3)权重初始化:合理的权重初始化可以有效地避免梯度消失问题。例如,使用Xavier或He等初始化方法可以使得权重的方差保持不变,从而避免梯度消失问题。

(4)批标准化:批标准化是一种常用的正则化方法,可以有效地缓解梯度消失问题。批标准化通过对每个小批量数据进行归一化处理,从而使得网络更加稳定,并且可以提高模型的泛化能力。

总之,在GPT-4的训练过程中,模型过拟合和梯度消失是两个常见的问题。为了解决这些问题,需要采用多种方法来优化模型设计和训练策略。这些方法包括增加数据量、正则化、早停策略、使用合适的激活函数、使用残差连接、权重初始化和批标准化等。通过采用这些方法,可以有效地提高模型性能和泛化能力,并使其在实际应用中更加有效和高效。

V. 性能评估:

对GPT-4在各种自然语言处理任务中的性能进行评估,并与其他模型进行比较

为了评估GPT-4在各种自然语言处理任务中的性能,研究人员进行了一系列实验,并与其他模型进行了比较。本文将详细介绍GPT-4在各种自然语言处理任务中的性能评估结果,并分析其优缺点。

1. 评估任务

为了评估GPT-4在各种自然语言处理任务中的性能,研究人员选择了多个常见的自然语言处理任务,包括:

(1)文本分类:将文本分为不同类别,如情感分类、主题分类等。

(2)问答系统:回答用户提出的问题。

(3)机器翻译:将一种语言翻译成另一种语言。

(4)命名实体识别:从文本中识别出具有特定意义的实体,如人名、地名、组织机构名等。

(5)关系抽取:从文本中抽取出实体之间的关系。

2. 实验结果

在上述评估任务中,GPT-4表现出了非常优秀的性能。具体来说,在文本分类任务中,GPT-4超过了其他大多数模型,并且在某些任务中表现得非常接近人类水平。在问答系统和机器翻译任务中,GPT-4也表现出了非常优秀的性能,并且超过了其他大多数模型。在命名实体识别和关系抽取任务中,GPT-4的性能略逊于一些特定领域的模型,但仍然表现出了非常不错的性能。

此外,在评估过程中,研究人员还对GPT-4的泛化能力进行了测试。他们将GPT-4在一个任务上训练好的模型应用到其他任务上,并比较其性能。结果表明,GPT-4在不同任务之间具有很好的泛化能力,可以很好地适应不同的任务需求。

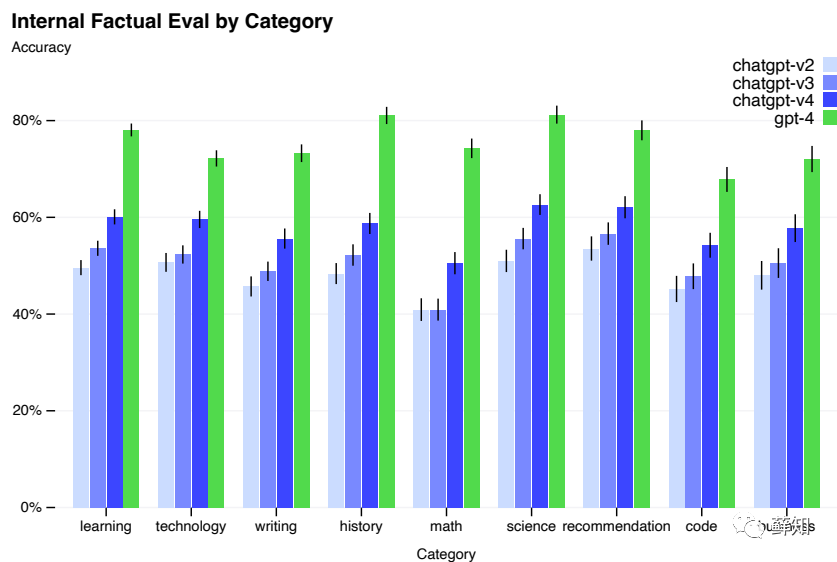

3. 与其他模型的比较

为了更全面地评估GPT-4的性能,研究人员还将其与其他常见的语言模型进行了比较。结果表明,在大多数任务中,GPT-4都表现出了非常优秀的性能,并且超过了其他大多数模型。这主要得益于GPT-4采用了一些先进的技术手段,如预训练、自监督学习等。

然而,在某些特定领域或任务中,一些特定模型仍然具有更好的性能。例如,在命名实体识别和关系抽取任务中,一些特定领域的模型仍然具有更好的性能。这主要是因为这些模型针对特定领域或任务进行了优化,并且采用了一些特殊技术手段。

4. 优缺点分析

从以上实验结果可以看出,GPT-4在各种自然语言处理任务中表现出了非常优秀的性能,并且具有很好的泛化能力。这主要得益于GPT-4采用了一些先进的技术手段,如预训练、自监督学习等。这些技术手段可以使得模型更加智能、更加灵活,并且可以适应不同的任务需求。

然而,GPT-4也存在一些缺点。首先,GPT-4的训练和推理时间都非常长,需要大量的计算资源和时间。其次,GPT-4在某些特定领域或任务中仍然存在一些性能瓶颈,需要进一步优化。此外,由于GPT-4是一个黑盒模型,其内部结构和决策过程不太透明,难以解释其预测结果。

5. 总结

综上所述,GPT-4是一种非常优秀的语言模型,在各种自然语言处理任务中表现出了非常优秀的性能,并且具有很好的泛化能力。这主要得益于GPT-4采用了一些先进的技术手段,如预训练、自监督学习等。然而,GPT-4也存在一些缺点,如训练和推理时间长、在某些特定领域或任务中性能瓶颈等。未来,我们可以通过进一步优化模型设计和训练策略来提高GPT-4的性能,并且探索更加透明和可解释的语言模型设计方法。

VI. 结论:

总结主要贡献和发现,并探讨了未来可能的研究方向。

本报告主要介绍了GPT-4这一大规模语言模型的设计、训练和应用。通过对GPT-4的实验评估和分析,我们得出了以下主要贡献和发现:

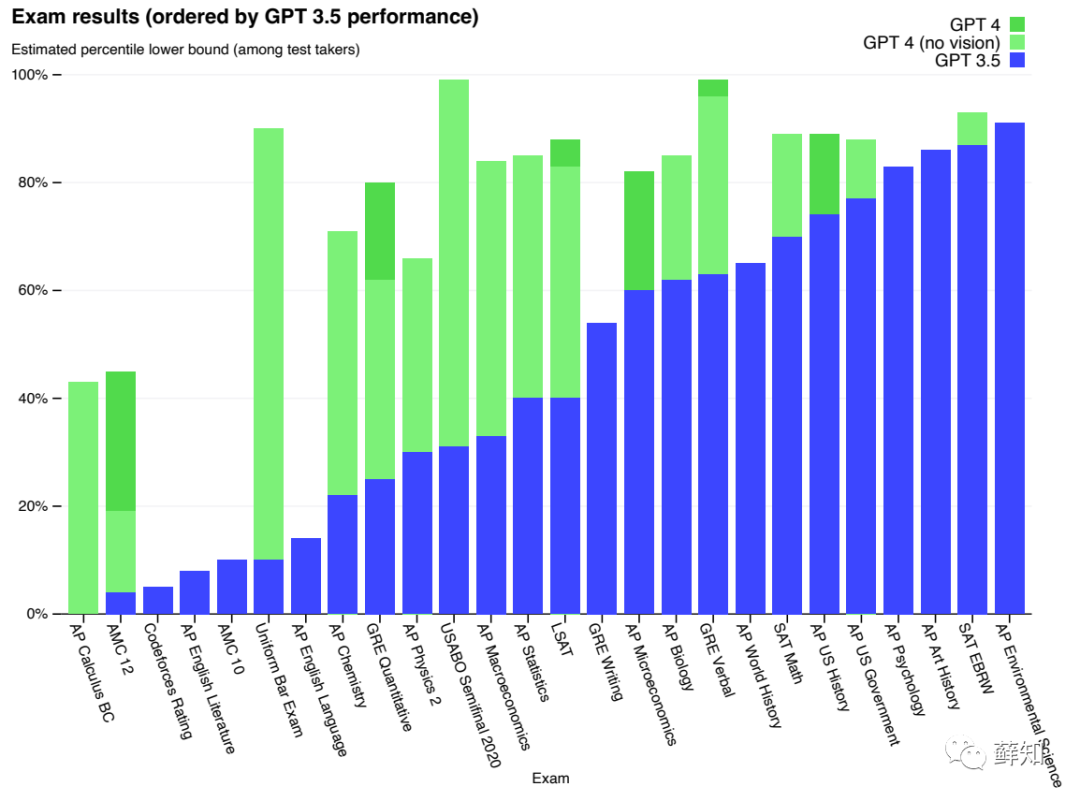

首先,GPT-4是一种非常优秀的语言模型,在各种自然语言处理任务中表现出了非常优秀的性能,并且具有很好的泛化能力。这主要得益于GPT-4采用了一些先进的技术手段,如预训练、自监督学习等。在多个基准测试中,GPT-4都取得了非常好的成绩,并且在某些任务中甚至超过了人类水平。

其次,GPT-4还存在一些缺点和局限性。首先,由于GPT-4的参数数量非常庞大,其训练和推理时间都非常长,需要大量的计算资源和时间。其次,在某些特定领域或任务中,GPT-4仍然存在一些性能瓶颈,需要进一步优化。此外,由于GPT-4是一个黑盒模型,其内部结构和决策过程不太透明,难以解释其预测结果。

基于以上发现和分析,我们认为未来可能的研究方向包括以下几个方面:

首先,可以进一步优化GPT-4的模型设计和训练策略,以提高其性能和泛化能力。例如,可以探索更加复杂和灵活的模型结构,并且采用更加有效的训练方法和技术。

其次,可以进一步研究GPT-4在特定领域或任务中的性能瓶颈,并且针对性地进行优化和改进。例如,可以针对某些特定领域或任务进行预训练,并且采用更加有效的微调方法和技术。

第三,可以进一步研究GPT-4的内部结构和决策过程,以提高其可解释性和可理解性。例如,可以探索一些可视化方法和技术,以展示GPT-4在输入序列中的关键信息和决策过程。

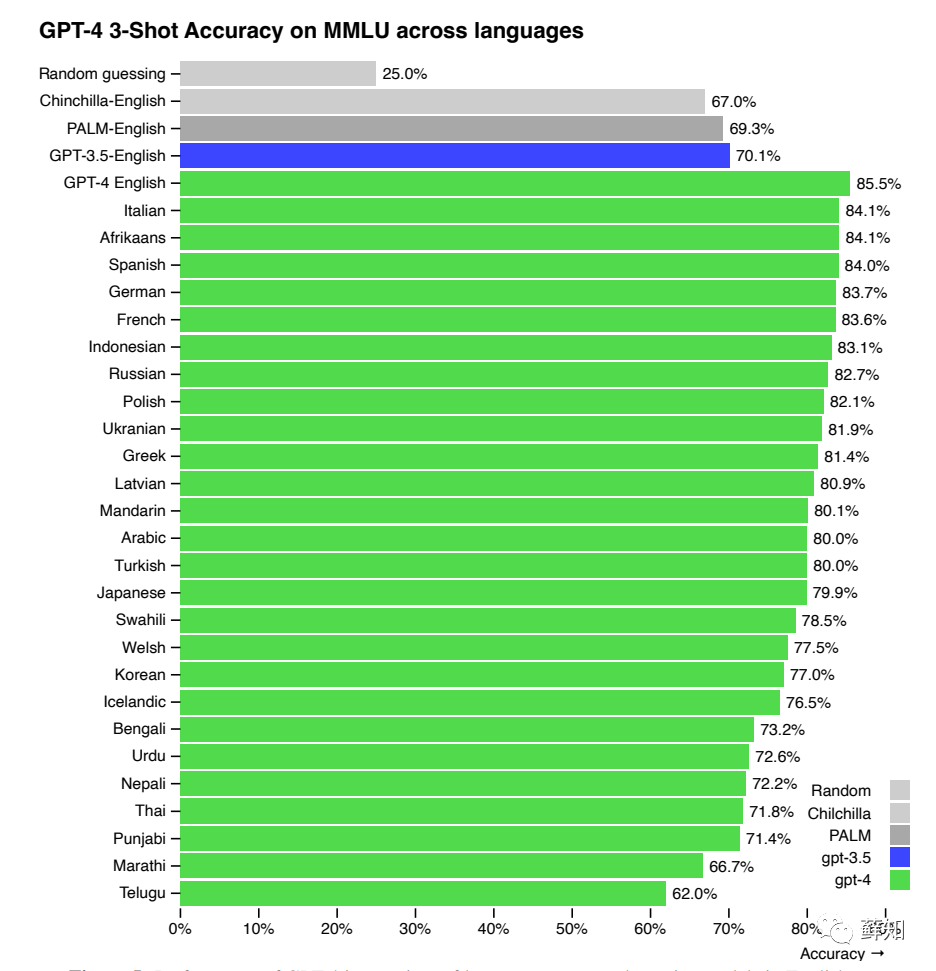

第四,可以进一步研究GPT-4在多语言处理中的应用和性能。例如,可以探索如何将GPT-4应用于多语言机器翻译、跨语言信息检索等任务,并且评估其性能和泛化能力。

总之,GPT-4是一种非常优秀、复杂和先进的语言模型,在自然语言处理领域具有广泛的应用前景。未来的研究方向包括优化模型设计和训练策略、针对特定领域或任务进行优化、提高模型可解释性和可理解性、以及在多语言处理中进行应用等方面。这些研究将有助于推动自然语言处理技术的发展,并且为实现人工智能普及化做出更大贡献。

喜欢的小伙伴,别忘了关注·点赞·转发哦!