浅析自然语言处理的生成式预训练模型GPT

前言

今天的GPT,是新一代的NLP模型。为了展现这个新模型的特征,我把传统的处理方法和基于统计模型的处理方法都隐掉,直接介绍GPT的核心思路。

01

什么是自然语言处理?

自然语言处理(Natural Language Processing,NLP)是计算机科学和人工智能领域的重要分支,它旨在使计算机能够理解、解析、生成和处理自然语言。

NLP的目标是让计算机和人类之间能够进行自然的语言交互,从而解决自然语言理解和生成的各种应用问题,如语音识别、机器翻译、文本分类、信息抽取、问答系统等。

NLP的新进展将为我们带来许多好处,如更加自然的语言交互、更高效的信息处理、更准确的语言理解等。

NLP技术可以帮助我们更好地理解和利用语言信息,从而更好地满足人们的需求。例如,在搜索引擎中使用NLP技术可以更精准地匹配用户的搜索意图,为用户提供更有价值的搜索结果;在智能客服中使用NLP技术可以更快速地解决用户的问题,提高客户满意度;在自然语言生成中使用NLP技术可以更自然地生成文本,使得文本表达更加清晰、准确。因此,NLP技术将会在未来的许多领域中发挥着重要的作用。

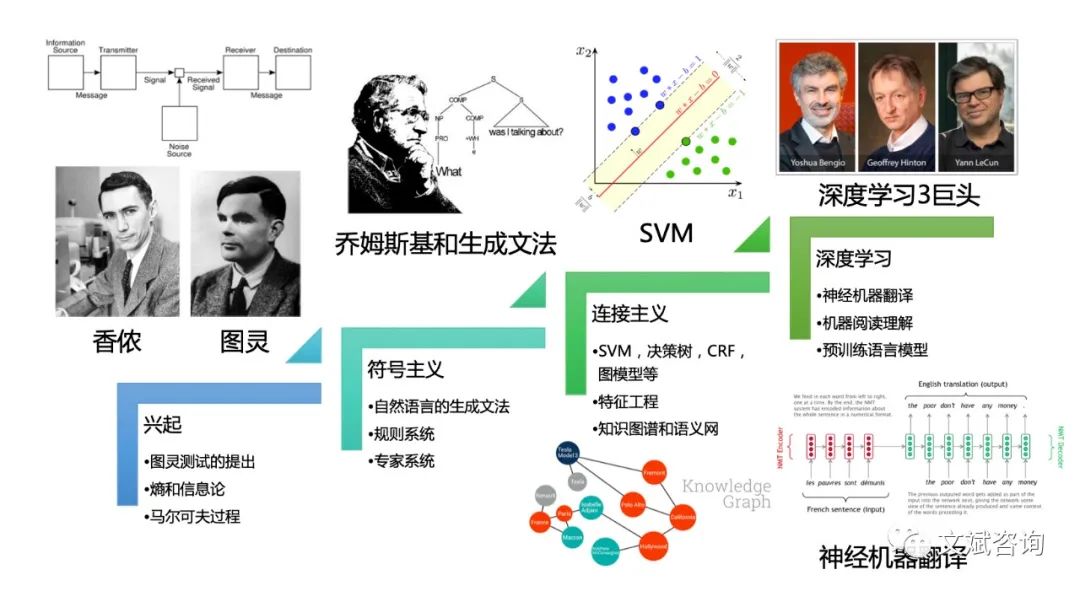

NLP的研究历史可以追溯到上个世纪50年代,传统模型主要采用规则和规则库来处理自然语言,但是这些方法往往受限于规则库的大小和复杂性。

随着统计模型的出现,如隐马尔科夫模型和条件随机场等,NLP的性能得到了进一步提升。而近年来,深度学习的兴起也使得NLP的性能得到了质的飞跃。

最新的预训练模型,如GPT-3,更是在NLP领域取得了令人瞩目的成绩。

02

为什么NLP这么难?

自然语言是一种复杂的符号系统,具有许多特征和规律。从自然语言的角度出发,我们可以归纳出自然语言的8个主要特性:

抽象性:自然语言是一种高度抽象的符号系统,语言符号和语言意义之间没有直接的关联,需要通过上下文和语境来理解。比如“树”,既可以是杨树柳树,也可以是树的通称,还可以是“建树”。

组合性:自然语言是由有限的语法规则和词汇单元组合成无限多种表达方式的系统,同样的词汇和语法规则可以组合成不同的句子。几千个汉字、单词,就有数不胜数的组合。

歧义性:自然语言中存在许多歧义和多义词汇,相同的句子在不同的语境下可能有不同的含义。比如“苹果”,可以是手机,可以是公司名,可以是水果。

进化性:自然语言是一种不断变化的符号系统,新的词汇和语法规则不断涌现,老的词汇和语法规则逐渐淘汰。比如“指鸭为鼠”。

非规范性:有意无意的非规范文本、错别字,也为自然语言处理带来了不小的挑战。比如“肿么了”。

主观性:自然语言中存在大量的主观因素,如情感、观点、价值观等,需要结合上下文和语境才能得出正确的理解。

知识性:自然语言的理解离不开背景知识和常识推理,需要结合丰富的知识库和知识图谱来进行推断和理解。比如”大猴子打了小猴子,它哭了“,这个“它”指代谁,需要有被打的那个更容易哭的隐含的背景知识。

难移植性:自然语言处理模型的训练和应用需要考虑特定的语言和文化背景,难以直接迁移到其他语言和文化背景。比如中文和英文的不同。

03

预训练语言模型GPT

经过了70多年的努力,随着大数据、大模型、大算力的条件成熟,OpenAI公司推出了一系列自然语言处理模型,其中之一的GPT就是一种基于深度学习的预训练语言模型。

GPT的全称,是Generative Pre-Trained Transformer(生成式预训练Transformer模型),是一个深度学习模型。

GPT采用了动态词向量表示、多头自注意力模型、Transformer模型、小样本学习等关键原理,使得模型在各种NLP任务上都具有很好的表现。目前,GPT-3.5、GPT-4模型都已经进入到日常生活当中使用,给我们带来了非常大的效率提升。

GPT的训练过程

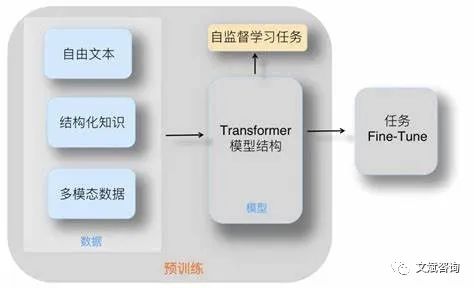

GPT-3的训练过程是一个非常复杂的过程,分为两个阶段:预训练和微调。

预训练阶段采用了一种基于自回归语言建模的方法,即给定前面的语言序列,预测下一个词的概率分布。这种语言模型的训练可以通过反向传播算法在大规模语料库上进行,得到一个高度精准的语言模型。预训练的目的是让模型学习到语言的一般规律和结构,从而为后续的微调任务提供基础。

然而,预训练阶段的计算量非常大,GPT-3有1750亿个参数,需要大量的计算资源和时间。为了解决这个问题,GPT-3采用了一种名为“自适应计算”的方法,即根据计算资源的变化自适应地调整模型的大小和计算量,从而获得更好的性能和效率。

在微调阶段,通过在特定的任务上进行有监督的微调,可以使得模型能够更好地适应具体的任务需求。这个阶段的任务可以是文本分类、文本生成、问答系统等。在微调阶段,使用的数据量相对较小,但是数据的标注信息相对比较详细,因此可以更加精细地调整模型参数。

关键算法/模型

GPT-3采用了一系列关键算法和模型,包括动态词向量表示、多头自注意力模型、Transformer模型、小样本学习等。这些算法和模型的作用是提高模型的语言理解和生成能力,使得模型在各种NLP任务上都具有很好的表现。

动态词向量表示:GPT-3采用了一种动态词向量表示方法,动态词向量表示方法的原理是将每个词的向量表示与其出现的位置相关联。这种方法可以更好地处理语言中的上下文信息,从而获得更好的性能。

相比之下,传统的词向量表示方法将每个单词表示成一个固定长度的向量,无法很好地捕捉上下文信息。因此,动态词向量表示方法是一种更加高效的表示方法,可以在自然语言处理任务中发挥更好的作用。

多头自注意力模型:多头自注意力模型是一种用于NLP任务的关键模型,可以帮助模型理解长文本序列中的关键信息。GPT-3采用了这种模型来进行语言建模和文本生成。多头自注意力模型可以让模型自动关注文本序列中的不同部分,从而更好地捕捉文本中的语义信息。

这种模型的优势在于它可以同时关注不同层面的信息,比如单词、短语和句子之间的关系。它还可以在处理长文本时有效地解决信息遗漏的问题。此外,多头自注意力模型可以通过调整不同头的权重来控制模型的关注程度,从而对不同类型的文本序列进行更好的建模。

Transformer模型:Transformer模型是一种基于自注意力机制的神经网络模型,可以用于各种NLP任务。GPT-3采用了Transformer模型来实现自然语言理解和生成,避免了传统的循环神经网络中存在的梯度消失和梯度爆炸问题。下文单独介绍。

小样本学习:小样本学习是一种在数据稀缺的情况下训练模型的方法。GPT-3采用了一种名为“Few-shot learning”的小样本学习方法,在仅有很少量的数据时也能取得很好的效果。这种方法通过将少量的训练数据和大量的未标注数据结合起来训练模型,从而提高了模型的泛化能力。

04

Transformer模型

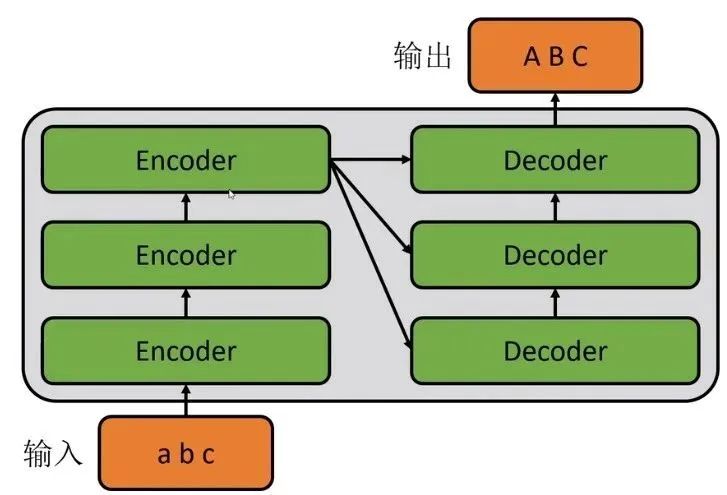

Transformer模型是一种基于自注意力机制的神经网络模型,用于序列到序列的学习,常用于机器翻译、文本生成、对话系统等任务。相较于传统的循环神经网络(RNN),Transformer模型可以并行计算,因此训练速度更快,同时还能够处理较长的序列。

Transformer模型由编码器和解码器组成,其中编码器将输入序列映射到隐层表示,解码器将隐层表示映射到输出序列。

编码器

编码器接收输入序列,并将其映射到一组隐藏表示。编码器由多个自注意力层和前馈神经网络层组成。自注意力层允许编码器在处理输入序列时动态地对不同位置的信息进行关注和加权。

自注意力层的输入包括三个向量:查询向量(query)、键向量(key)和值向量(value)。查询向量可以理解为当前位置的词,键向量和值向量则对应于输入序列中的其他位置。通过计算查询向量和键向量之间的点积,然后将得到的值除以一个缩放因子,得到一个注意力权重向量。最后,将注意力权重向量与值向量的加权和,作为自注意力层的输出。

多个自注意力层通过残差连接和层归一化技术进行连接,最后通过前馈神经网络层将隐层表示映射到固定维度。

解码器

解码器接收编码器的隐层表示,并生成输出序列。解码器也由多个自注意力层和前馈神经网络层组成,但相比编码器,解码器需要额外的注意力机制来关注编码器的输出。

解码器首先输入一个特殊的标记,用于表示开始生成序列。然后,通过自注意力机制和编码器-解码器注意力机制,生成每个位置的输出。解码器的每个位置都需要关注输入序列中的所有位置,因此需要使用编码器-解码器注意力机制。

编码器-解码器注意力机制是一种将查询向量来自解码器,键向量和值向量来自编码器的注意力机制,可以帮助解码器关注编码器中与当前位置相关的信息。

GPT应用解码器

GPT模型的训练过程分为预训练和微调两个阶段。

在应用解码器进行训练时,输入序列的前缀是已知的,模型的任务是生成给定前缀后面的文本。模型的训练目标是最大化生成文本的概率。具体地,模型在每个位置生成一个单词,并根据已生成的单词和给定前缀计算下一个单词的概率分布。模型的输出是一系列单词的序列,可以用于文本生成等任务。这种“自回归”的生成方式可以保证生成的文本流畅自然,但是会导致生成速度较慢。

综上所述,GPT-3采用了一系列先进的算法和模型来实现自然语言处理任务。这些算法和模型不仅提高了模型的性能,而且也为NLP领域的研究和应用带来了新的思路和方法。预训练语言模型GPT-3的出现,为NLP的发展提供了新的契机和挑战。

05

总结

NLP的新进展将为我们带来许多好处,如更加自然的语言交互、更高效的信息处理、更准确的语言理解等。GPT等最新的NLP模型的出现,为我们提供了更好的工具和技术,有望推动NLP的研究和应用取得更大的突破。

推荐阅读: